- Falcon H1R 7B bringt fortschrittliche Argumentation in einem kompakten Modell mit 7 Milliarden Parametern unter, das auf Schnelligkeit und Effizienz ausgelegt ist

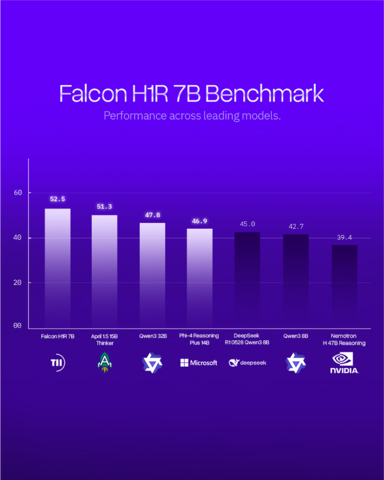

- Das neueste KI-Modell von TII übertrifft größere Konkurrenten von Microsoft, Alibaba und NVIDIA in zentalen Benchmarks

Das Technology Innovation Institute (TII), die Säule für angewandte Forschung des Advanced Technology Research Council (ATRC) in Abu Dhabi, hat die Veröffentlichung von Falcon H1R 7B bekannt gegeben, einem KI-Modell der nächsten Generation, das einen bedeutenden Schritt in Richtung einer noch nie dagewesenen Zugänglichkeit fortschrittlicher KI darstellt, indem es erstklassige Argumentationsleistung in einem kompakten, effizienten und frei verfügbaren Format liefert.

Diese Pressemitteilung enthält multimediale Inhalte. Die vollständige Mitteilung hier ansehen: https://www.businesswire.com/news/home/20260105526442/de/

TII Launches Falcon Reasoning: Best 7B AI Model Globally, Also Outperforms Larger Models (Graphic: AETOSWire)

Mit nur 7 Milliarden Parametern fordert Falcon H1R 7B größere Open-Source-KI-Modelle aus aller Welt heraus und übertrifft diese in vielen Fällen sogar, darunter Modelle von Microsoft (Phi 4 Reasoning Plus 14B), Alibaba (Qwen3 32B) und NVIDIA (Nemotron H 47B).Diese Version des Modells verdeutlicht die führende Position von TII im Bereich effizienter KI-Innovationen und festigt den wachsenden Einfluss der Vereinigten Arabischen Emirate als weltweiter Technologieführer.

Seine Exzellenz Faisal al Bannai, Berater des Präsidenten der Vereinigten Arabischen Emirate und Generalsekretär des Advanced Technology Research Council, sagte: "Falcon H1R spiegelt das Engagement der Vereinigten Arabischen Emirate wider, eine offene und verantwortungsbewusste KI zu entwickeln, die einen echten nationalen und globalen Mehrwert schafft. Durch die Integration von erstklassigen Denkprozessen in ein kompaktes, effizientes Modell erweitern wir den Zugang zu fortschrittlicher KI auf eine Weise, die das Wirtschaftswachstum, die Führungsrolle in der Forschung und die langfristige technologische Widerstandsfähigkeit stärkt."

Ein Durchbruch im Bereich Test-Time Reasoning

Falcon H1R 7B baut auf der Grundlage von Falcon H1-7B auf und verfügt über einen speziellen Trainingsansatz sowie eine hybride Transformer-Mamba-Architektur, die sowohl die Treffsicherheit als auch die Geschwindigkeit erhöht.

"Falcon H1R 7B stellt einen großen Fortschritt in der Denkfähigkeit kompakter KI-Systeme dar", sagte Dr. Najwa Aaraj, CEO von TII. "Es erzielt nahezu perfekte Ergebnisse bei Elite-Benchmarks und hält gleichzeitig den Speicher- und Energieverbrauch außergewöhnlich niedrig entscheidende Kriterien für den Einsatz in der Praxis und für die Nachhaltigkeit."

Dieser Ansatz erschließt das, was Forscher "latente Intelligenz" nennen, und ermöglicht es Falcon H1R 7B, effektiver und effizienter zu argumentieren. Das Modell setzt eine neue Pareto-Grenze, einen optimalen Performance-Punkt, an dem eine Erhöhung der Geschwindigkeit nicht mit Qualitätseinbußen einhergeht.

Benchmarking der Besten

In Wettbewerbsvergleichen erzielte Falcon H1R 7B überragende Ergebnisse:

- Mathematik: Mit 88,1 bei AIME-24 übertraf es das Apriel 1.5 (15B) (86,2 %) von ServiceNow AI und bewies damit, dass ein kompaktes 7B-Modell mit weitaus größeren Systemen mithalten und sie sogar übertreffen kann.

- Codierungs- und Agenten-Aufgaben: Mit 68,6 Genauigkeit erzielte es die beste Leistung unter den Modellen unter 8B und erreichte höhere Punktzahlen in den Benchmarks LCB v6, SciCode Sub und TB Hard, wobei Falcon H1R mit 34 besser abschnitt als Chinas DeepSeek R1-0528 Qwen 3 8B (26,9 %) und sogar größere Konkurrenten wie Qwen3-32B (33,4 %) übertraf.

- Allgemeine Argumentation: Zeigte starke logische Fähigkeiten und die Fähigkeit, Anweisungen zu befolgen, und erreichte dabei eine Leistung, die der von größeren Modellen wie Microsofts Phi 4 Reasoning Plus (14B), entspricht oder nahekommt, wobei es nur halb so viele Parameter verwendete.

- Effizienz: Dank der hybriden Transformer-Mamba-Architektur wurden bei Batch 64 bis zu 1.500 Tokens/Sek./GPU erreicht, was fast dem Doppelten der Geschwindigkeit des chinesischen Qwen3-8B entspricht und das bei schnellerer, skalierbarer Leistung ohne Beeinträchtigung der Genauigkeit.

"Dieses Modell ist das Ergebnis von Forschung und Entwicklung auf Weltklasseniveau. Es zeigt, wie wissenschaftliche Präzision und skalierbares Design Hand in Hand gehen können", sagte Dr. Hakim Hacid, Chief Researcher am Artificial Intelligence and Digital Research Centre des TII. "Wir sind stolz darauf, ein Modell zu liefern, das es der Community ermöglicht, intelligentere, schnellere und besser zugängliche KI-Systeme zu entwickeln."

Open Source und auf Community gestützt

Im Einklang mit dem Engagement von TII für Transparenz und Zusammenarbeit im Bereich der KI wird Falcon H1R 7B als Open-Source-Modell unter der Falcon TII-Lizenz veröffentlicht. Entwickler, Forscher und Institutionen weltweit können über Hugging Face auf das Modell zugreifen, zusammen mit einem vollständigen technischen Bericht, in dem die Trainingsstrategien und die Leistung bei wichtigen Benchmarks für das logische Denken detailliert beschrieben werden.

Diese neue Version baut auf dem weltweiten Erfolg des Falcon-Programms von TII auf. Seit ihrer Einführung zählen die Falcon-Modelle durchweg zu den weltweit leistungsstärksten KI-Systemen, wobei die ersten vier Generationen in ihren jeweiligen Kategorien jeweils den ersten Platz in der globalen Rangliste belegten. In aufeinanderfolgenden Iterationen hat Falcon neue Maßstäbe in Bezug auf Leistung, Effizienz und Einsatzfähigkeit in der Praxis gesetzt und damit gezeigt, dass kompakte, souveräne Modelle deutlich größere Systeme übertreffen können. Diese Erfolge unterstreichen die wachsende Führungsrolle Abu Dhabis und der gesamten Vereinigten Arabischen Emirate im Bereich der zukunftsweisenden KI sowie die Fähigkeit von TII, weltweit wettbewerbsfähige Forschung zu betreiben.

*Quelle: AETOSWire

Die Ausgangssprache, in der der Originaltext veröffentlicht wird, ist die offizielle und autorisierte Version. Übersetzungen werden zur besseren Verständigung mitgeliefert. Nur die Sprachversion, die im Original veröffentlicht wurde, ist rechtsgültig. Gleichen Sie deshalb Übersetzungen mit der originalen Sprachversion der Veröffentlichung ab.

Originalversion auf businesswire.com ansehen: https://www.businesswire.com/news/home/20260105526442/de/

Contacts:

Jinan Warrayat

jinan.warrayat@tii.ae